使用MaxKB搭建一个本地知识库系统(智能客服实战篇)

写在最前面:如果你还没有观看上一篇教程,可以点击跳转在Windows系统上使用WSL部署vLLM开源大模型框架

如果您是个人用户,我更推荐使用Ollama搭建后端Windows请点击我 Linux请点击我

一、关于MaxKB

市面上有很多开源免费的知识库系统,比如Dify和n8n以及本次教程介绍的MaxKB

MaxKB(Max Knowledge Base)是一款基于大语言模型(LLM)的开源知识库问答系统,由杭州飞致云信息科技有限公司开发。该系统旨在为企业提供强大的知识管理和智能问答功能,广泛应用于企业内部知识库、客户服务、学术研究与教育等场景。

开箱即用:支持直接上传文档、自动爬取在线文档,支持文本自动拆分、向量化、RAG(检索增强生成),提供良好的智能问答交互体验。

无缝嵌入:支持零编码快速嵌入到第三方业务系统,让已有系统快速拥有智能问答能力,提高用户满意度。

灵活编排:内置强大的工作流引擎,支持编排 AI 工作流程,满足复杂业务场景下的需求。

模型中立:支持对接各种大语言模型,包括本地私有大模型(如 Llama 3、Qwen 2 等)、国内公共大模型(如通义千问、智谱 AI、百度千帆、Kimi、DeepSeek 等)和国外公共大模型(如 OpenAI、Azure OpenAI、Gemini 等)。

环境要求: 操作系统:Ubuntu 22.04 / CentOS 7 64 位系统 CPU / 内存:推荐 2C/4GB 以上 磁盘空间:100GB 浏览器要求:Chrome、FireFox、Edge 等现代浏览器 可访问互联网

本期教程使用Docker部署MaxKB,比起二进制部署,使用容器部署更加方便管理,也可以和系统资源实现相互隔离互不干扰

二、部署Docker

1.Windows部署流程

在Docker官网下载(可选)如果你的网络条件不错可以选择使用此方法

如下图所示

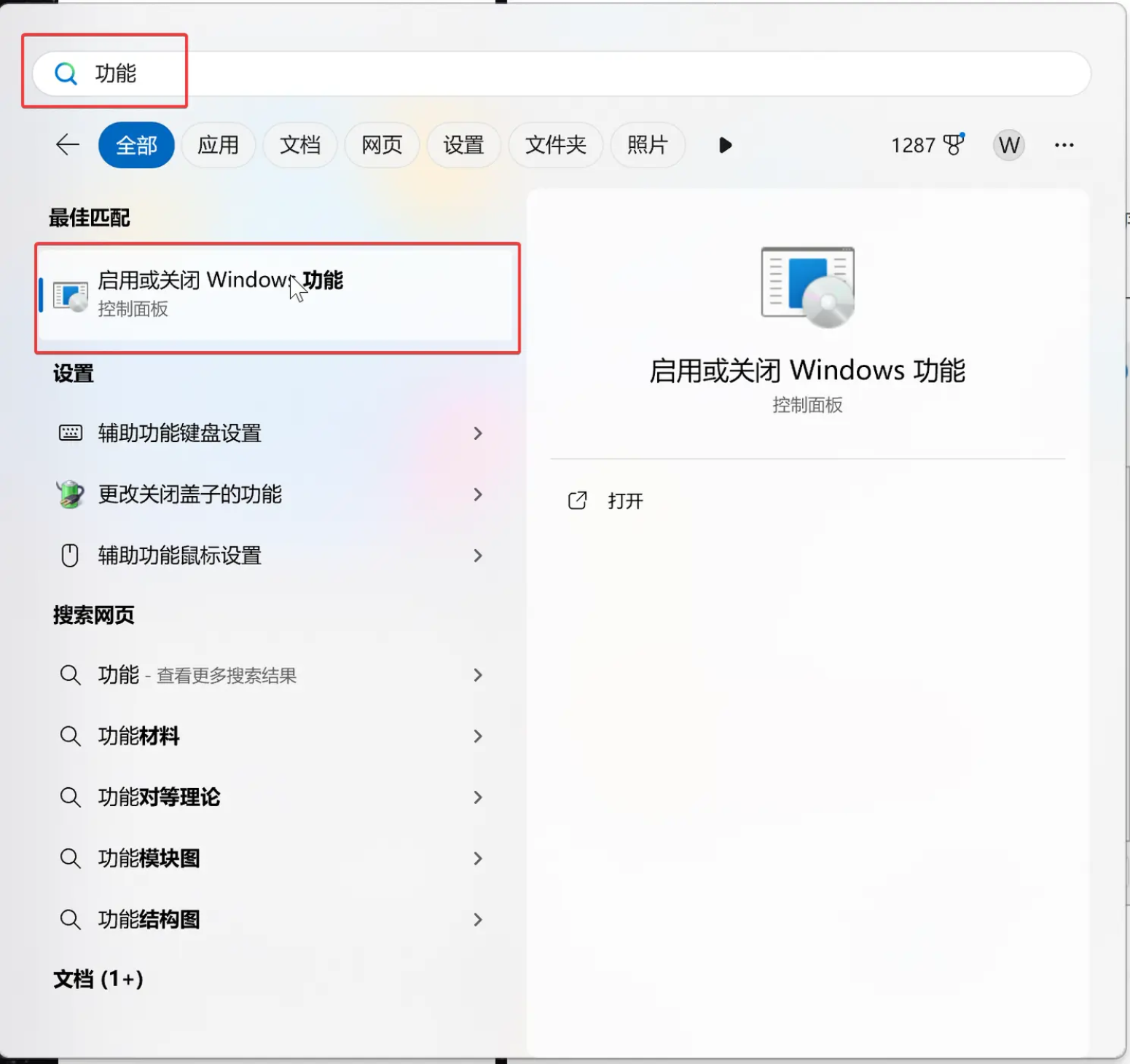

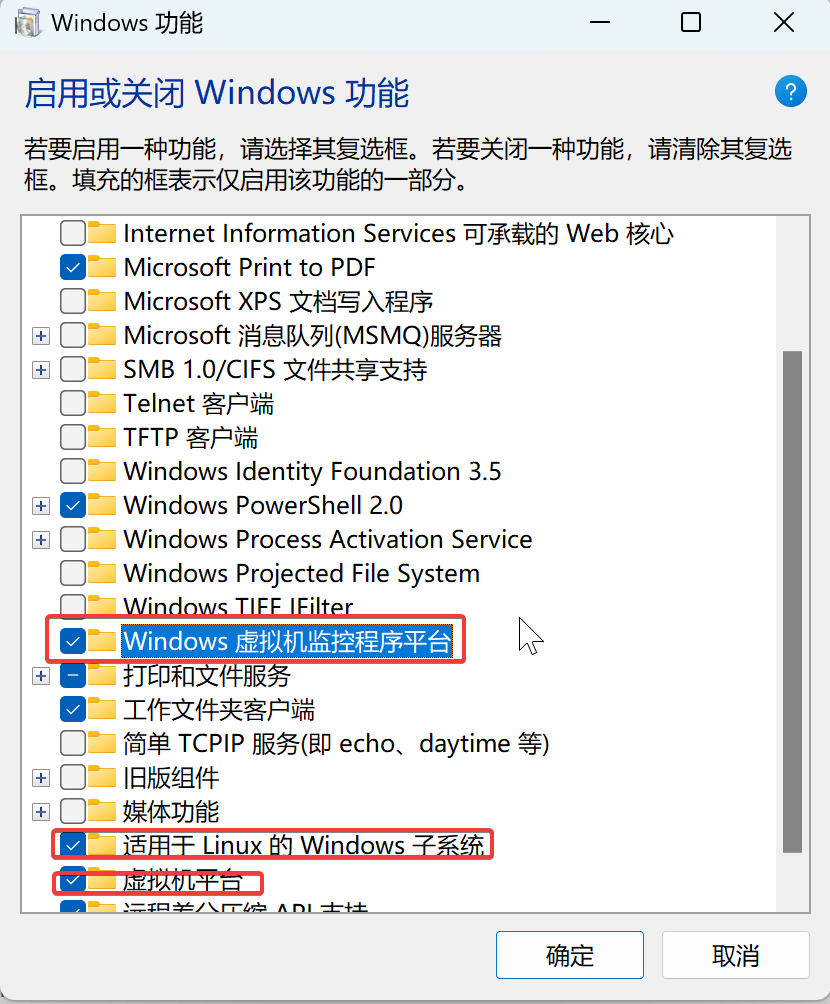

1.启用WSL功能

按照图上操作,并且重启系统后即可

2.设置WSL2为默认版本

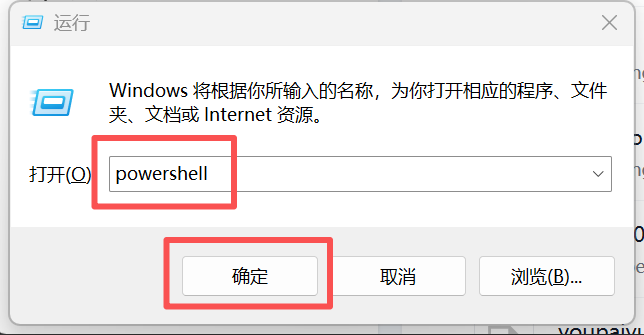

使用win+R运行打开powershell

在powershell中输入以下指令

wsl --set-default-version 2

3.升级下载WSL2的组件

wsl --update

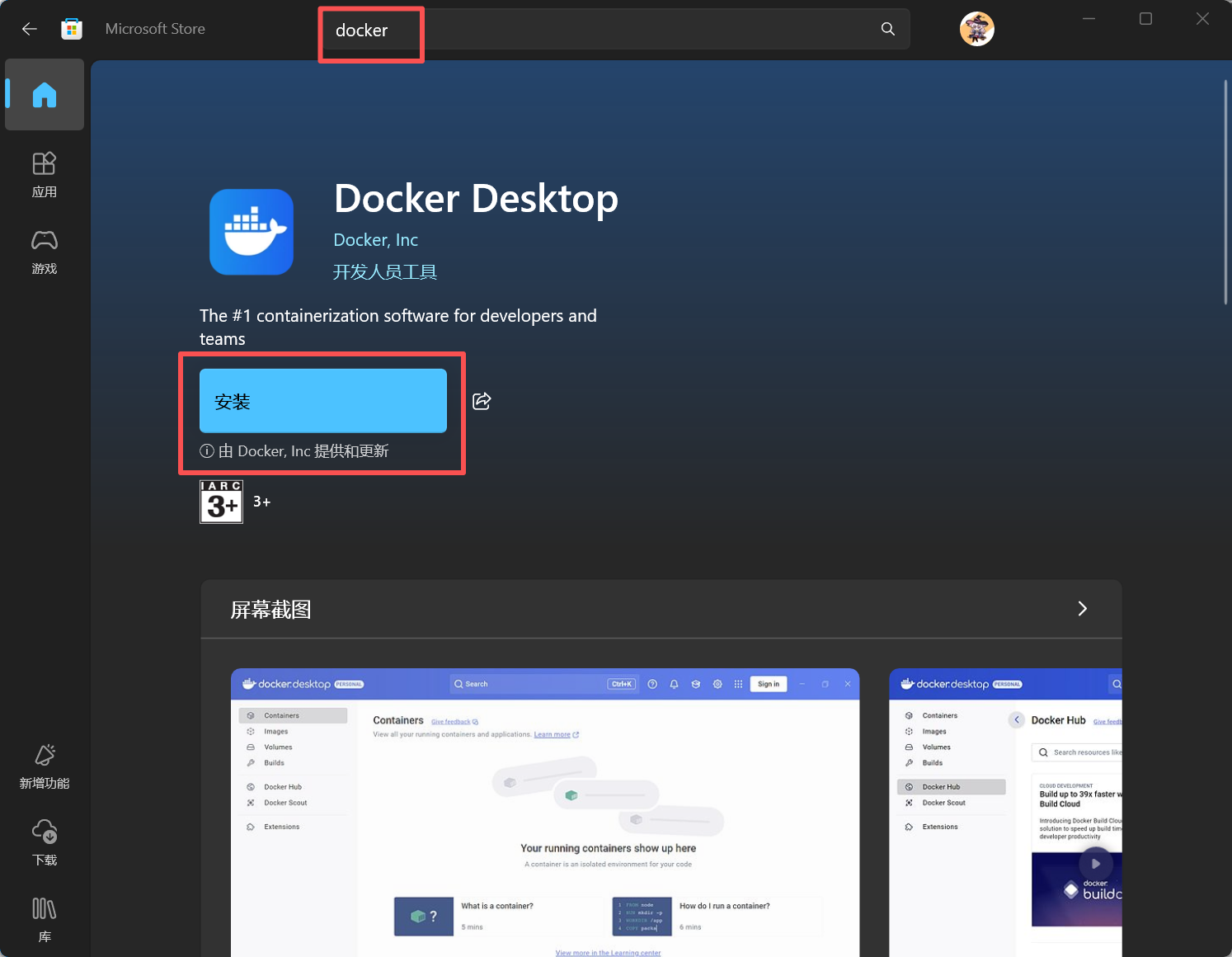

4.安装Docker Desktop

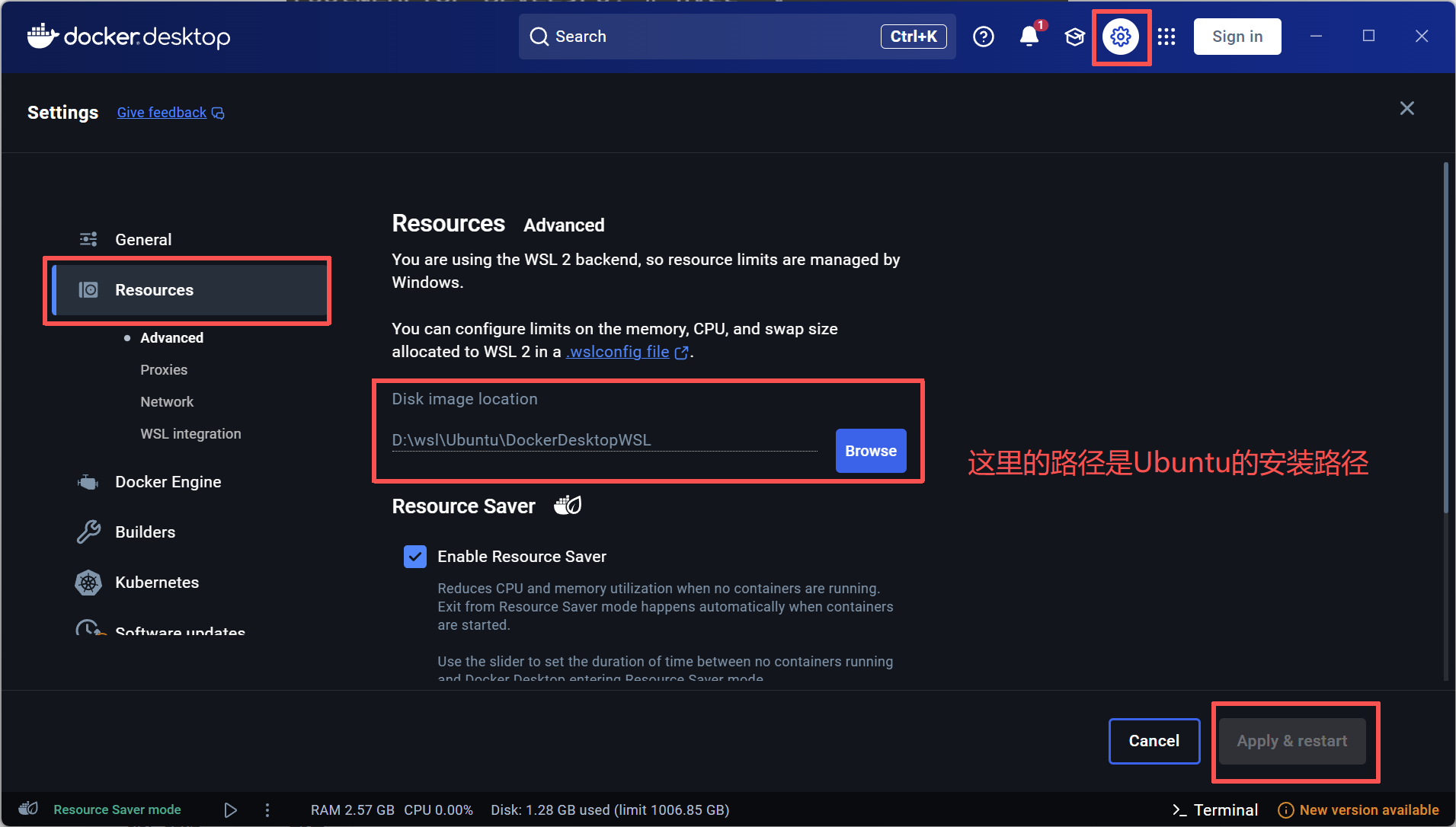

此步骤是为了上一篇教程我在本地部署的ubuntu作为容器的载体,如果您还没有安装,可以使用默认参数

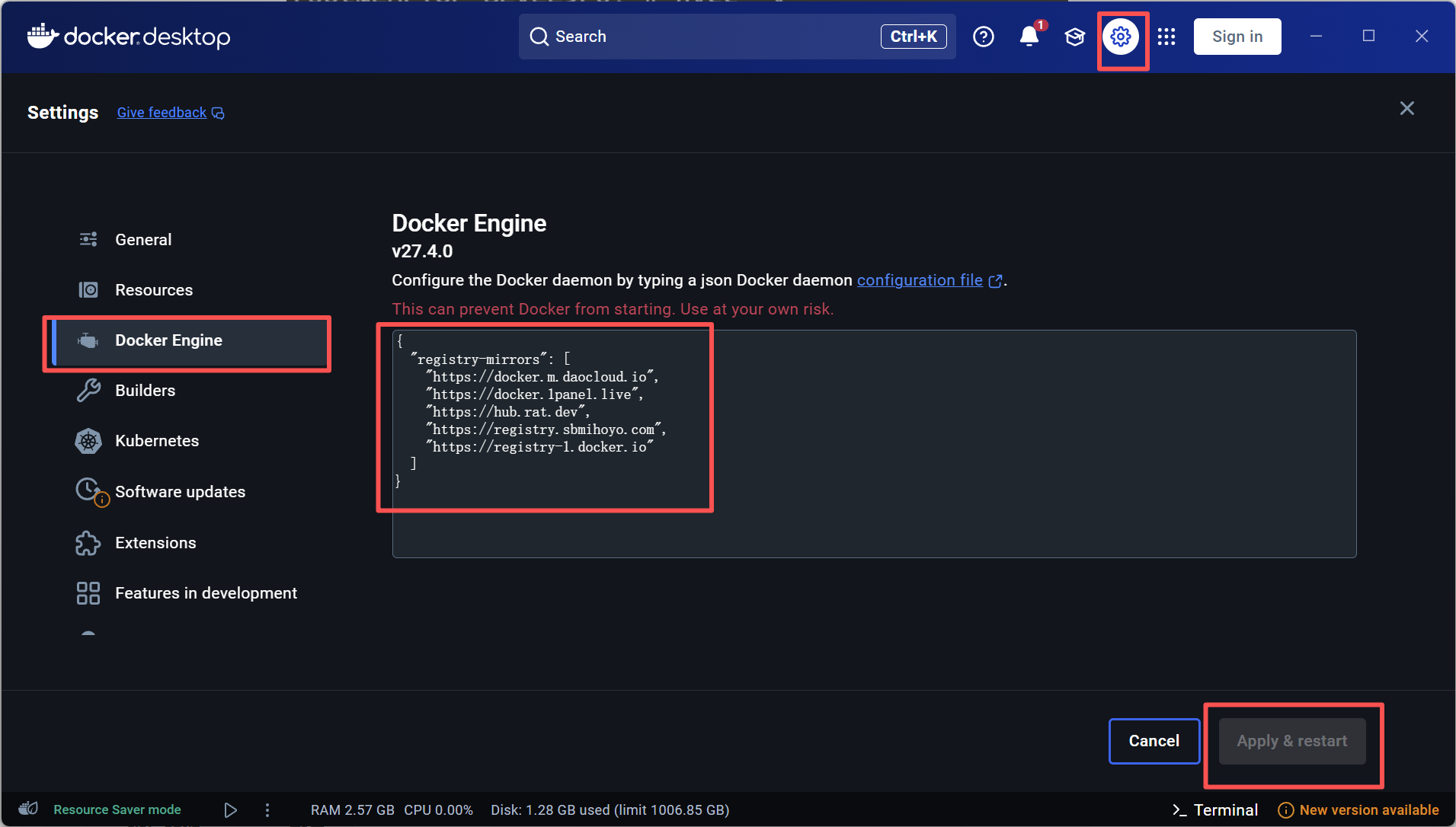

5.配置镜像加速

{

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://docker.1panel.live",

"https://hub.rat.dev",

"https://registry.sbmihoyo.com",

"https://registry-1.docker.io"

]

}

2.Linux部署流程

可以观看这期教程【容器应用系列教程】容器介绍、Docker的安装和基本操作 - 网笙久久的博客

三、部署MaxKB

更多Docker使用命令请移步【容器应用系列教程】容器介绍、Docker的安装和基本操作 - 网笙久久的博客

登录ubuntu输入以下命令

docker run -d --name=maxkb --restart=always -p 8080:8080 -v ~/.maxkb:/opt/maxkb registry.fit2cloud.com/maxkb/maxkb

| 参数 | 详情 |

|---|---|

| -d | 保持后台运行 |

| --name | 指定容器名称 |

| --restart | 指定持久运行策略 |

| -p | 映射端口 |

| -v | 持久化存储位置 |

四、配置MaxKB

1.登录MaxKB后台管理

浏览器打开输入本机IP地址+8080端口即可访问

http://目标服务器 IP 地址:8080

默认登录信息

用户名:admin

默认密码:MaxKB@123..

2.配置大模型

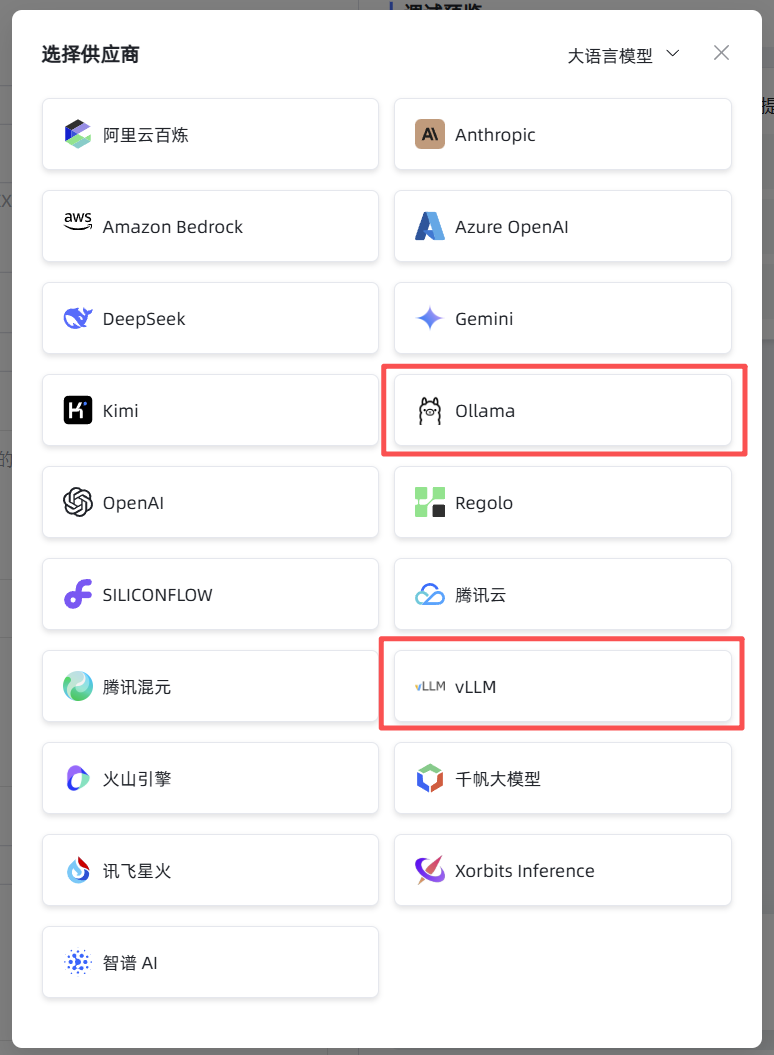

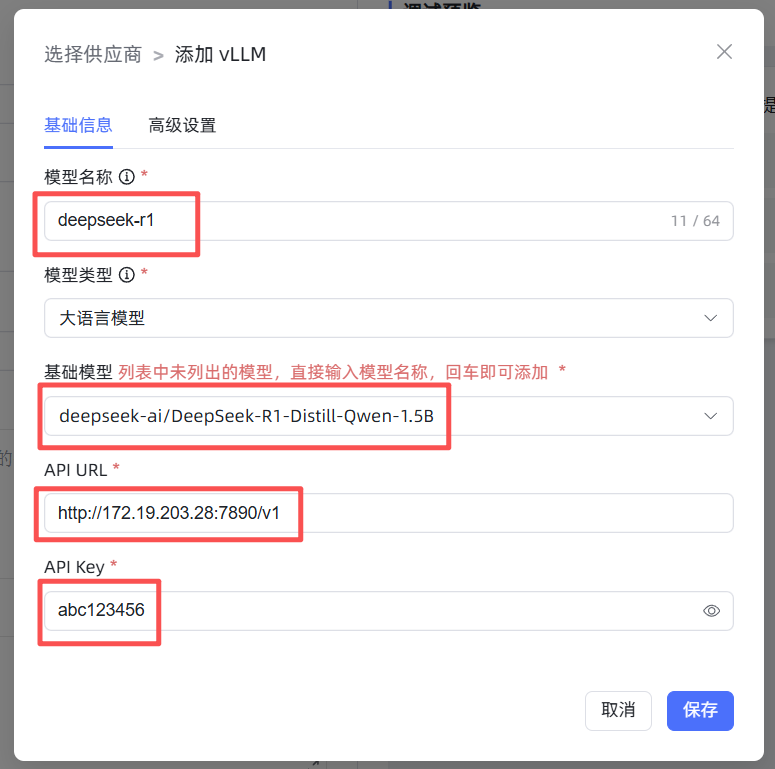

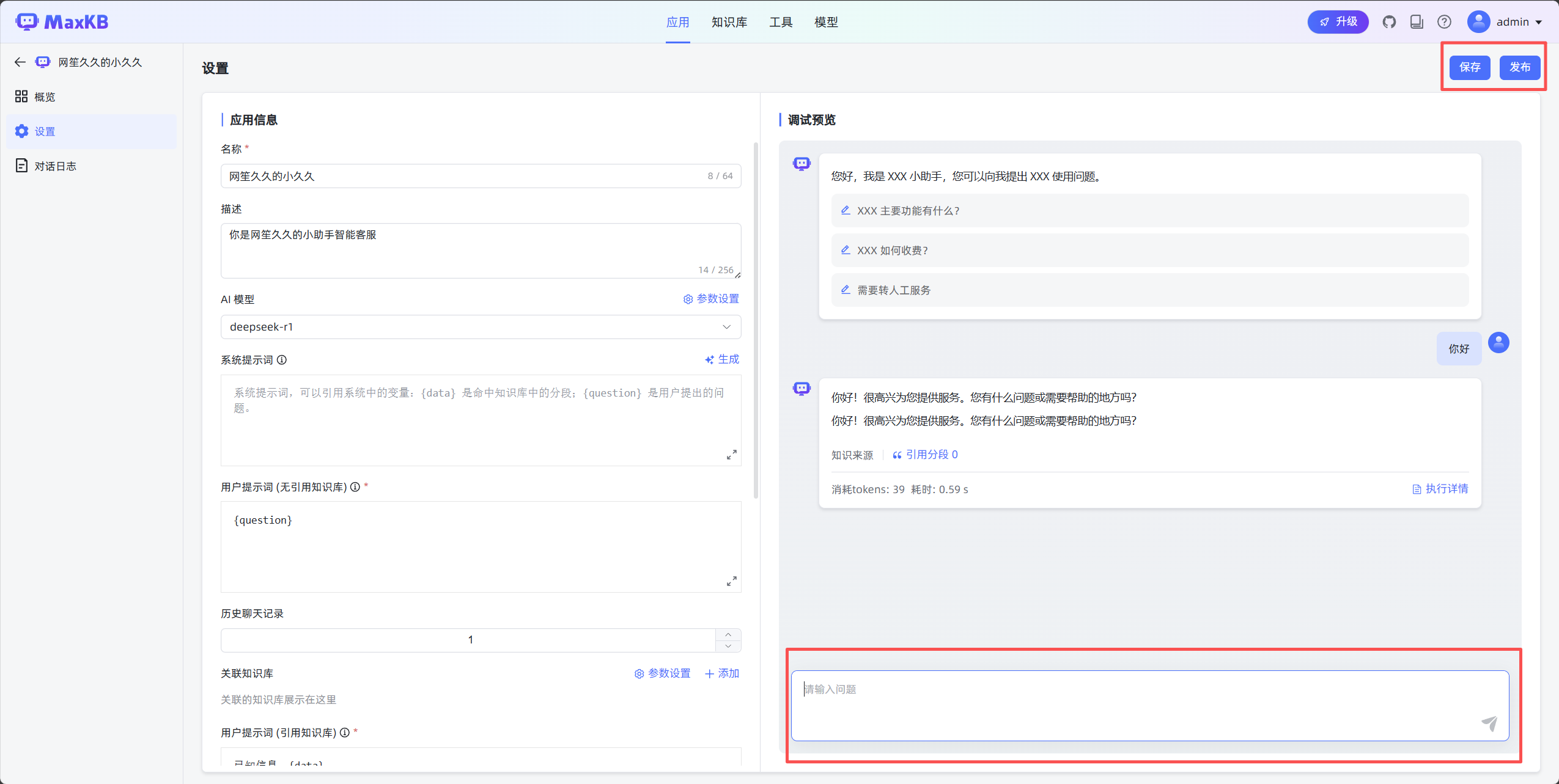

如下图所示

在正式配置本地模型前,需要手动启用vLLm

conda activate vllm-env

vllm serve /root/app/models/deepseek-r1 --api-key abc123456 --served-model-name deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B --max_model_len 4096 --gpu-memory-utilization 0.6 --port 7890

更多API对接接口可参考对接vLLM - MaxKB 文档

测试可用性

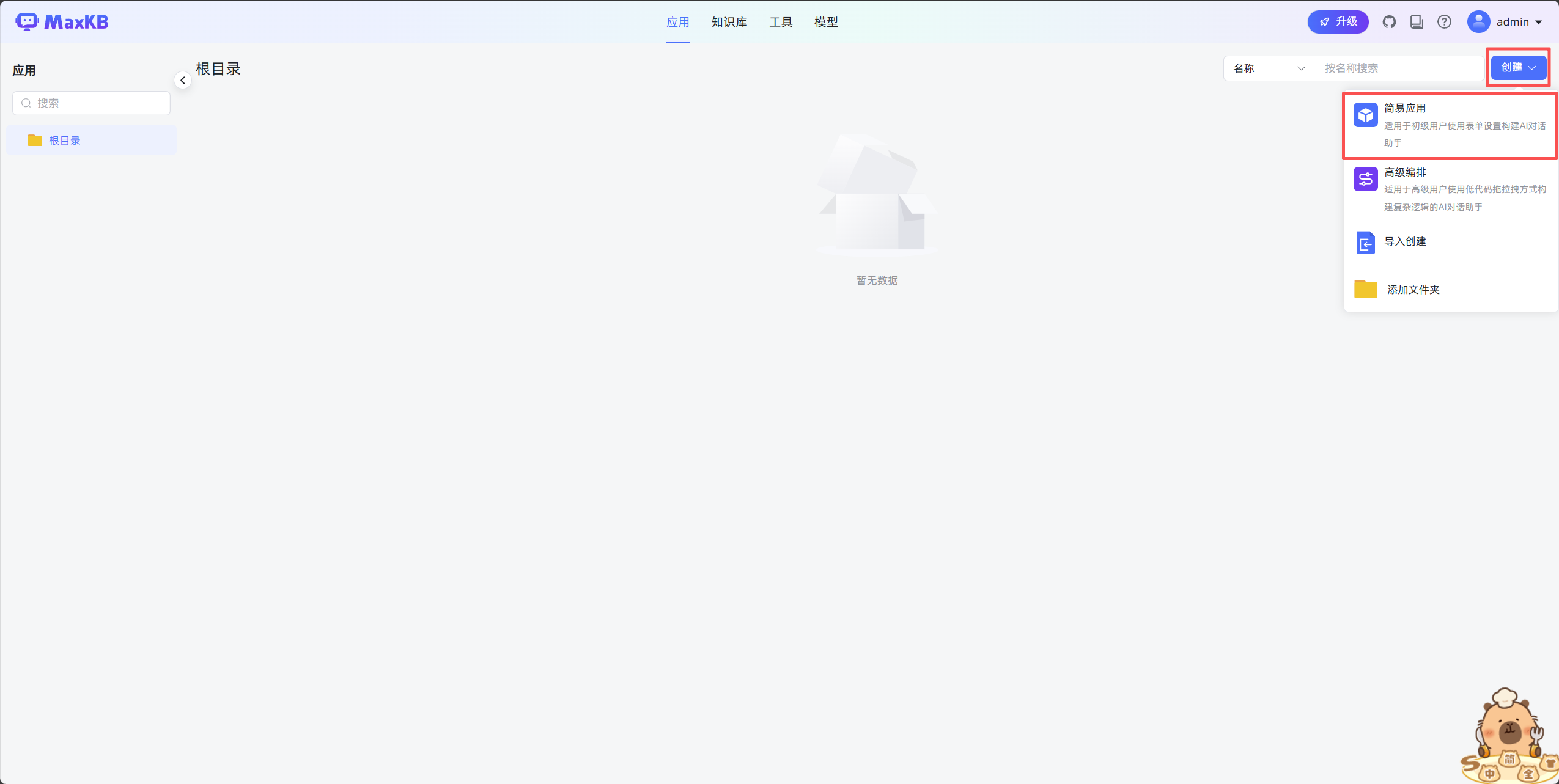

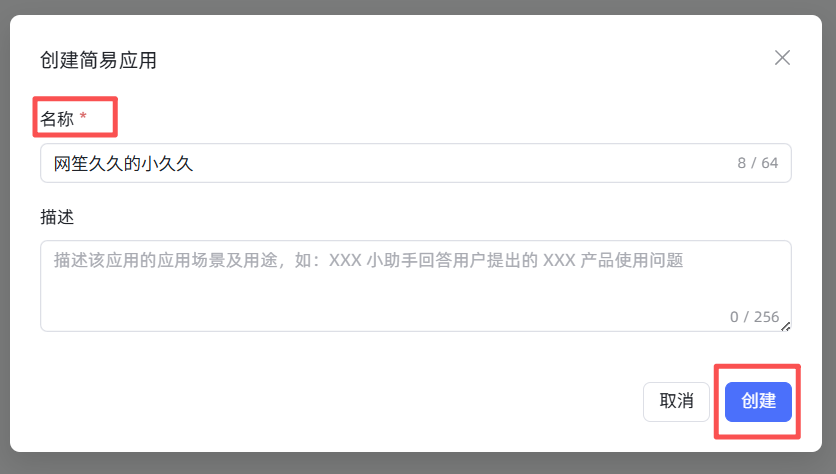

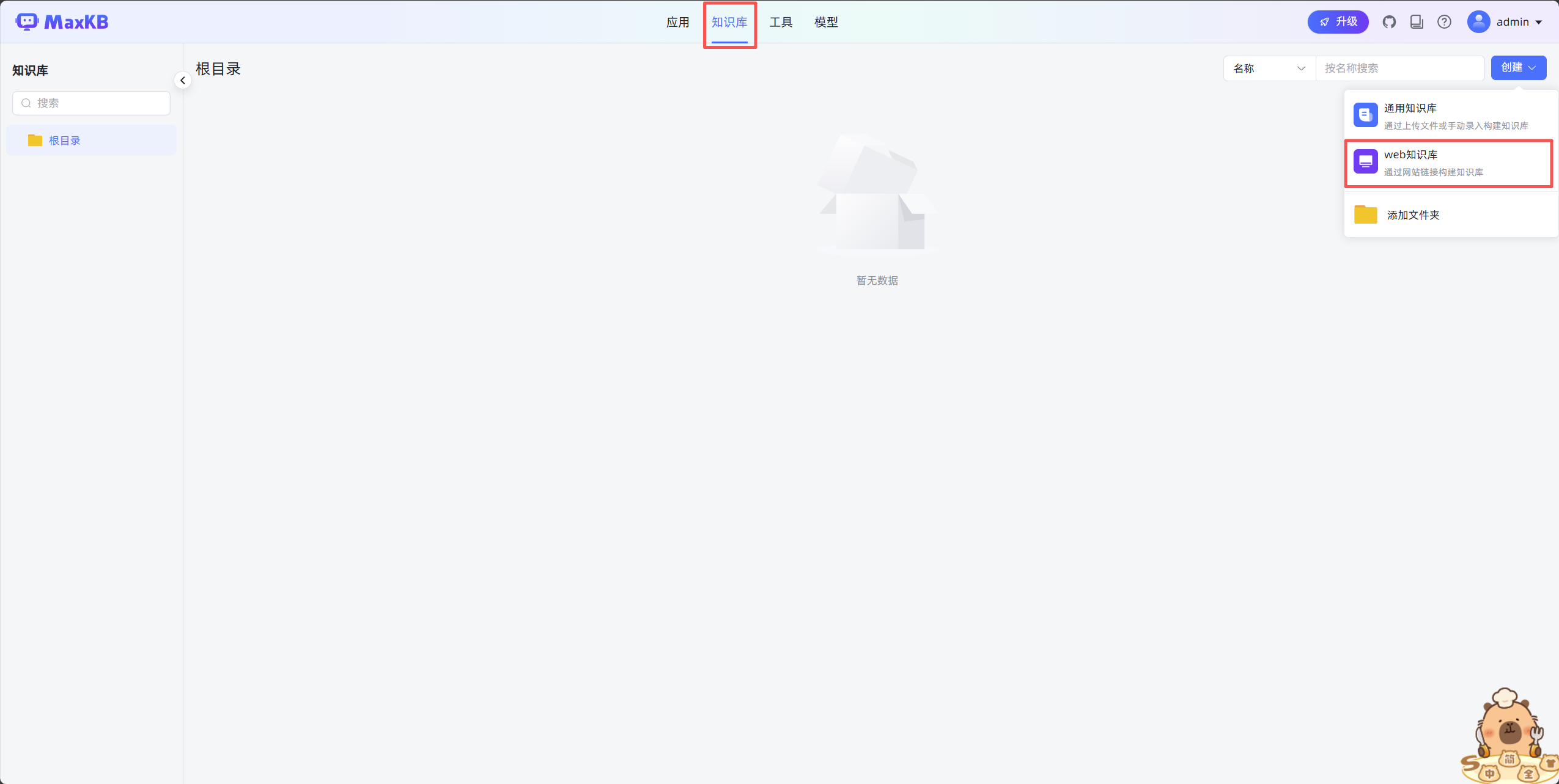

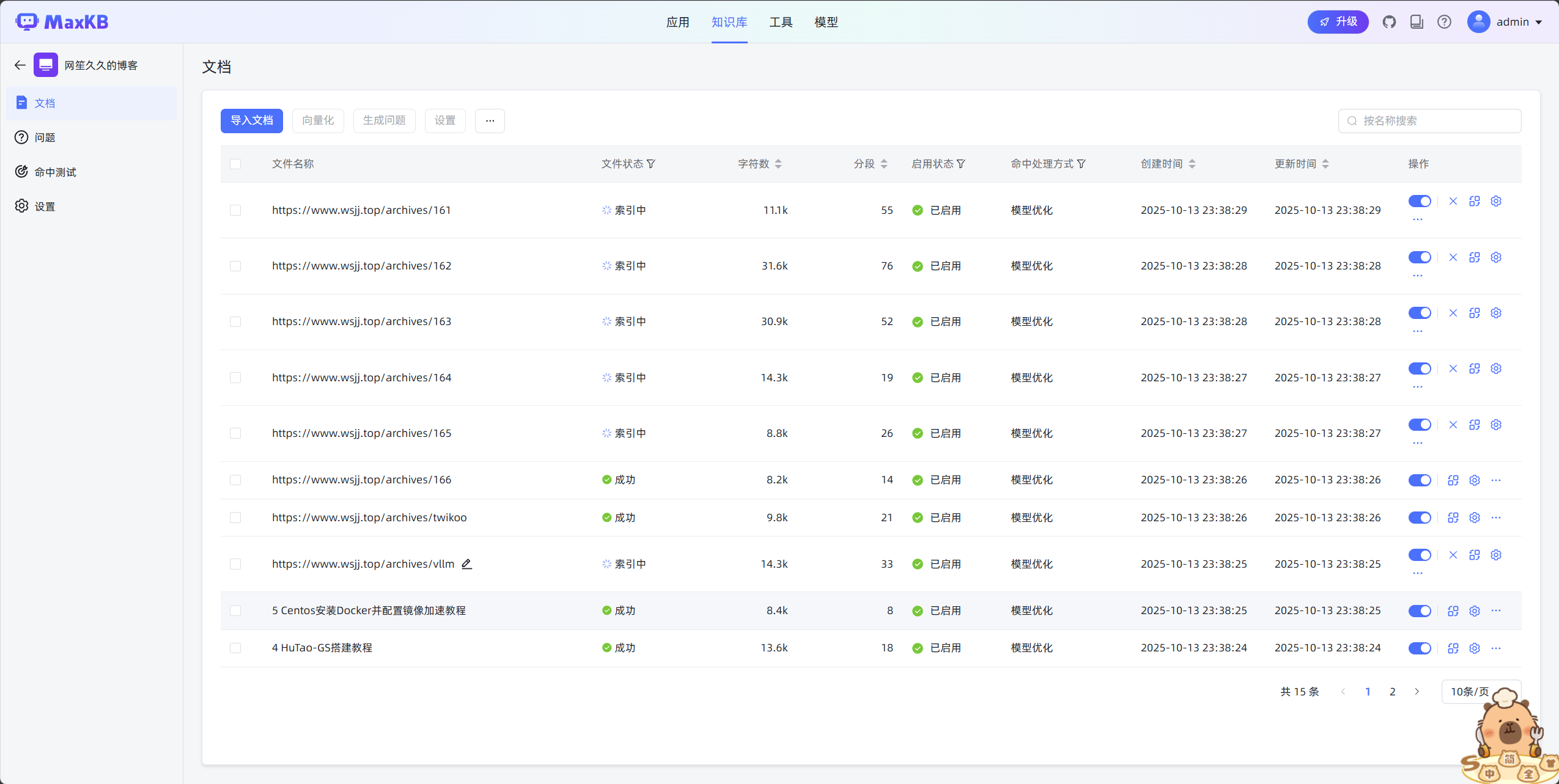

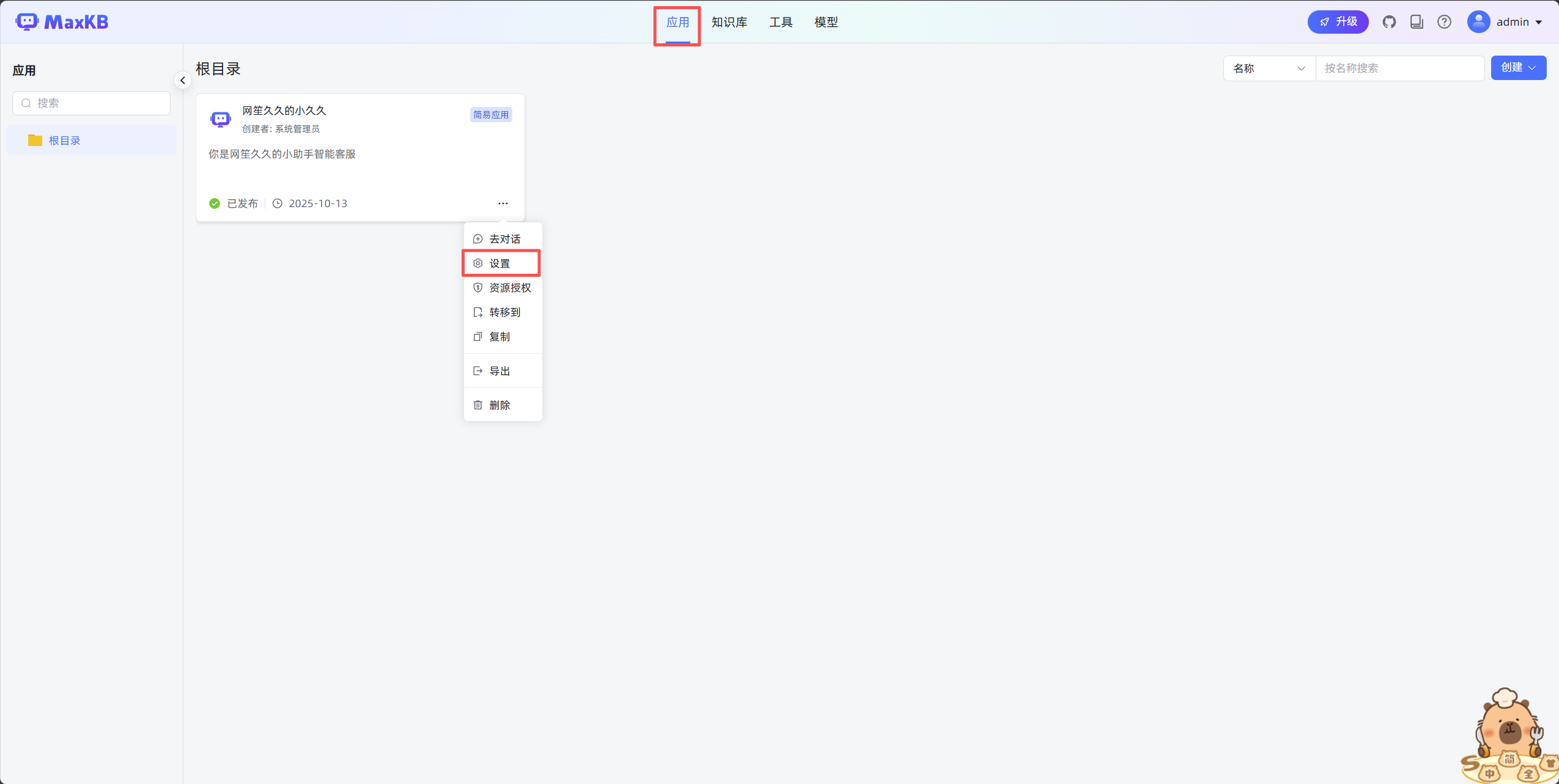

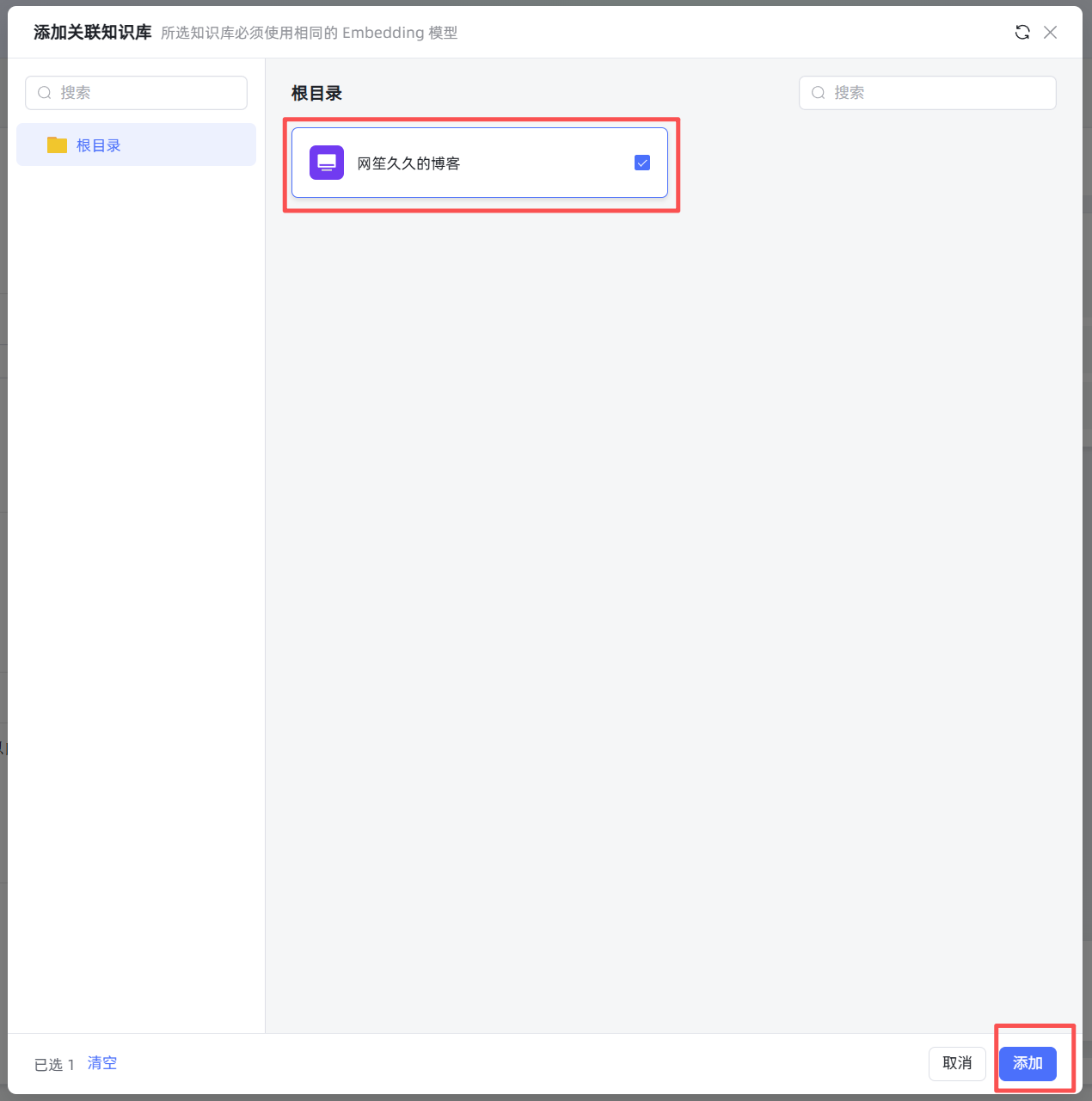

2.配置知识库

我这里用我的博客地址https://www.wsjj.top作为数据来源

3.测试知识库数据准确性

到此,一个简单的知识库系统就搭建完成了,您可以根据您自己的选择,在详细配置界面自定义您的小助手的各项属性和提示词部分

【AI大模型系列教程】使用MaxKB搭建一个本地知识库系统(智能客服实战篇)

https://www.wsjj.top/archives/maxkb

评论